Dziedzictwo kulturowe cz.II by Kaz 2009-12-21 04:34:10

Zgodnie z zapowiedzią, mam przyjemność przedstawić interesujący

referat Grzegorza Gałęzowskiego z Archiwum Państwowego w

Lublinie na temat nośników danych. Dotychczas z treścią tej pracy

mieli okazję zapoznać się zawodowi archiwiści i historycy. Jednak

jej tematyka jest na tyle fascynująca, a jednocześnie została

przedstawiona przez Grzegorza językiem logicznym i zrozumiałym, co

nota bene coraz rzadziej się zdarza, że czytelnicy AOL także

powinni mieć pożytek z zapoznania się z tekstem. Tym bardziej, że

toczyliśmy już tutaj dyskusje i spory na temat trwałości nośników

czy sposobów archiwizacji naszych zasobów atarowskich, a teraz

dostajemy do rąk więcej argumentów i przede wszystkim - więcej

konkretnych danych wspierających te argumenty:

Trwałość dokumentów cyfrowych na tle nośników tradycyjnych

Salvador Dali tak właśnie przedstawił w swoim obrazie upływ czasu i jego wpływ na przedmioty materialne. Odporność nośników danych na procesy starzenia jest ważnym problemem współczesnej cyfrowej archiwistyki i informatyki. Konwencjonalne nośniki, takie jak np. papier i cyfrowe nośniki danych, są prawdziwą pamięcią naszej cywilizacji, a ich zniszczenie może spowodować potężny kryzys w skali całego świata.

Cyfrowe nośniki danych starzeją się bardzo szybko, mimo tego że zapisane na nich dane nie poddają się teoretycznie niszczącemu działaniu czasu. Jednak fizycznych nośników, na których je zapisujemy, na pewno nie można uważać za niezniszczalne.

Rewolucja informatyczna coraz intensywniej stara się zastępować papier cyfrowymi nośnikami danych. Cyfrowe wersje dokumentów możemy jednak bezpowrotnie stracić, jeśli nie będą podejmowane odpowiednie działania zaradcze.

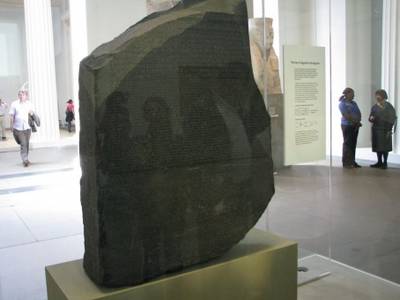

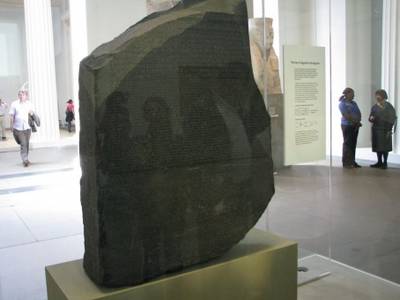

Cyfrowe nośniki danych nie oddziałują bezpośrednio na zmysły człowieka, tak jak chociażby znaleziony w 1799 roku w czasie wyprawy Napoleona bazaltowy dokument, sporządzony w klasycznej grece oraz w transkrypcji hieroglificznej.

Pozostaje zadać sobie pytanie, czy następne pokolenia będą miały szansę na odczytanie „nowoczesnych”, zdigitalizowanych zasobów archiwów.

Człowiek od wieków przechowuje informacje zapisywane na wielu różnych, trwałych nośnikach. Należą do nich: kamienie, tabliczki z wypalonej gliny, płytki metalowe, drewno, kora, liście, jedwab i inne tkaniny, sznurek, kości, skorupy żółwi, muszle, skóra, pergamin, papier, papirus, szkło, skały, ściany i mury budowli.

Spośród wymienionych nośników największe znaczenie ma niewątpliwie papier, który zaczęto wytwarzać w Chinach w II wieku n.e. Papierowy nośnik informacji może mieć formę pojedynczej kartki, zwoju lub książki. Znalezienie informacji zapisanej na zwoju wymaga dłuższego czasu niż w książce, którą można otworzyć w dowolnym miejscu. Papier charakteryzuje się dość dużą trwałością, dlatego też w języku angielskim wydruk na papierze to hard copy – czyli kopia trwała. Początkowo informacja na papierze była zapisywana ręcznie, ręcznie także kopiowano informacje. Po wynalezieniu przez Chińczyków, a później przez Gutenberga, czcionek ruchomych i prasy drukarskiej informację zaczęto nanosić na papier mechanicznie. Wynalazek ten pozwolił przyspieszyć zapis informacji, a także umożliwił tworzenie wielu identycznych kopii informacji. Papierowe nośniki danych były także stosowane w systemach komputerowych.

Zapisany nośnik przechowywany jest w określonym środowisku. Oddziaływanie czynników zewnętrznych na nośnik może doprowadzić do zniekształcenia lub całkowitego usunięcia zmian wywoływanych podczas zapisu – poprawny odczyt jest wtedy niemożliwy. Dodajmy, że może dojść do sytuacji, w której odczyt jest możliwy, jednak interpretacja tego, co odczytano jest niemożliwa. Dzieje się tak wtedy, kiedy nośnik przetrwał, ale informację zapisano z użyciem niezrozumiałego, w momencie odczytu, języka. Na Krecie w drugim tysiącleciu p.n.e. stosowano pismo nazywane obecnie linearnym A. Tabliczki gliniane z tekstami zapisanymi tym pismem przetrwały do dzisiaj. Mimo, iż umieszczone na nich symbole są rozpoznawalne, nie można zinterpretować ich znaczenia.

Historia nośników

Terminem nośnik informacji będziemy określali obiekt materialny, na którym jest utrwalona określona informacja w postaci fizycznych zmian własności obiektu.

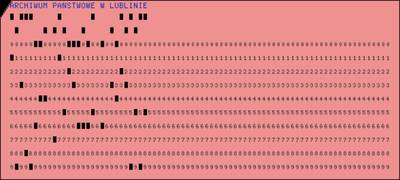

Karta perforowana

Karty i taśmy perforowane były stosowane we francuskich warsztatach tkackich, szafach grających, pianolach, tabulatorach, a wreszcie w komputerach. Po raz pierwszy karty perforowane zostały zastosowane w krosnach tkackich. W 1725 roku Basile Bouchon wprowadził perforowane karty papierowe do krosna nicielnicowego. Zastosowanie kart z otworami pozwoliło częściowo zautomatyzować pracę krosna. Od rozmieszczenia otworów na karcie zależał wzór tkany na płótnie. W kolejnych latach oprócz kart stosowano także walce perforowane, zwoje papieru i zestawy kart połączonych ze sobą. Najbardziej znane i najpowszechniej stosowane były krosna budowane na początku XIX wieku przez Josepha Marie Jacuarda.

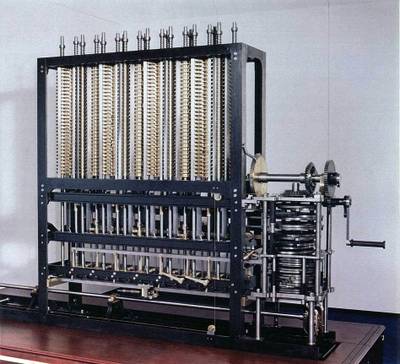

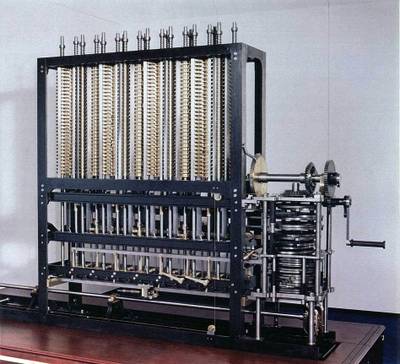

Użycie kart perforowanych planował także Charles Babbage w swoim projekcie maszyny analitycznej z 1840 roku. W krosnach karty sterowały działaniem, natomiast Babbage zamierzał zastosować różne typy kart do dwóch celów: sterowania i wprowadzania wartości liczbowych. Zakładał także, że karty najczęściej używane byłyby wykonane z blachy cynkowej. Ze względu na brak możliwości technologicznych, maszyny Babbage’a nie

zbudowano w tamtym okresie. Pierwszy egzemplarz maszyny został zbudowany dopiero pod koniec lat 80. XX wieku. Urządzenie okazało się w pełni sprawne i zdolne dokonywać obliczeń z dokładnością do 31 cyfr, co wielokrotnie przekracza możliwości współczesnego kalkulatora kieszonkowego.

W 1887 Herman Hollerith opatentował własny format karty dziurkowanej, która została użyta podczas powszechnego spisu ludności USA w 1890 roku. Opracowany na te potrzeby system kodowania zbieranych informacji oparty był właśnie na tych kartach. Informacje kodowano poprzez wycinanie otworów w odpowiednich miejscach, gdy odpowiedź na pytanie była twierdząca. Karty mogły być następnie segregowane lub zliczane, w zależności od wyciętych otworów. Karta Holleritha miała wymiary ówczesnego banknotu dolarowego tzn. 90 na 215 mm, otwory były okrągłe.

Informacja na nośniku papierowym jest najczęściej naniesiona na powierzchnię i zapisana jako tekst, rysunek lub obraz, ale może być także reprezentowana przez odpowiednie ukształtowanie krawędzi kartki lub wykonanie otworów w jej powierzchni.

W najprostszym wypadku informacja jest reprezentowana przez brak lub obecność pojedynczego otworu w dowolnym miejscu papierowego nośnika – oczywiście ta metoda daje możliwość reprezentowania pojedynczego bitu informacji. Znacznie więcej możliwości daje stosowanie wielu otworów i ustalenie miejsc ich pojawienia się na nośniku papierowym.

Zaletą zapisu za pomocą otworów, w odniesieniu do tekstu czy obrazu umieszczonego na kartce, była w przeszłości możliwość mechanicznego lub elektrycznego wykrywania istnienia otworów, a więc odczytywania informacji bez udziału człowieka, a następnie automatycznego wykonywania czynności zależnej od odczytanej informacji.

Podobną możliwość automatycznego odczytywania zapisu z nośnika daje stosowanie atramentu przewodzącego prąd. Próby użycia takiej technologii podjęto w połowie lat trzydziestych XX wieku. Przykładowo, w 1937 roku w firmie IBM opracowano maszynę o nazwie IBM Type 805 International Test Scoring Machine, do automatycznego podliczania wyników testów wypełnianych przy użyciu takiego atramentu.

Wkrótce po wprowadzeniu do użytku kart perforowanych i maszyn sortujących znaleziono dla nich wiele innych zastosowań. Używano ich między innymi na kolei i w towarzystwach ubezpieczeniowych. W miarę upływu czasu doskonalono i wprowadzano nowe urządzenia. W 1901 opatentowano klawiszową dziurkarkę kart. Pięć lat później opracowano automatyczny podajnik kart, pracujący z szybkością 150 kart/min.

Pierwsze karty pozwalały na zapisanie odpowiedzi typu „tak/nie” lub „1 z wielu”. Stopniowo wprowadzano karty umożliwiające wyrażanie liczb, a następnie liczb i tekstów.

Z upływem lat karty perforowane stały się nośnikiem danych stosowanym masowo. Przykładowo, pod koniec lat trzydziestych XX wieku przedsiębiorstwo kolejowe w Czechach zużywało około 50 mln kart rocznie. Drukarnia kart w Warszawie wytwarzała 36 mln kart rocznie. Przed II wojną światową we Francji zużywano około 200 mln kart rocznie. Na początku lat czterdziestych XX wieku produkcja kart perforowanych w Niemczech wynosiła 1,5 mld rocznie. Używane w tych latach tabulatory segregowały z szybkością do 25 tysięcy kart/h.

Biorąc pod uwagę fakt, że na pojedynczej, 80-kolumnowej karcie kodowano do osiemdziesięciu znaków (równorzędnych używanym dziś osiemdziesięciu bajtom) i że każde 80 bajtów miało grubość 0,18 milimetra, można oszacować, że do zakodowania 80 gigabajtów dysku twardego potrzebny byłby stos kart o wysokości ponad 0,18 miliarda milimetrów, czyli 180 kilometrów, ważący ponad dwa tysiące ton.

System dziurkowanych kart jako nośników danych, jak już wspomniano, w zasadzie wyszedł z użycia w latach 80., choć stosowano go jeszcze incydentalnie również później. Szczególnie głośny stał się przypadek jego zastosowania w czasie amerykańskich wyborów prezydenckich w roku 2000, kiedy nieprawidłowo opracowany system kodowania danych w połączeniu z typowym dla perforowanych papierowych nośników danych problemem pozostających w otworach resztek doprowadził do skandalu i potrzeby ponownego, ręcznego sprawdzenia wszystkich kart w stanie Floryda.

Taśmy magnetyczne

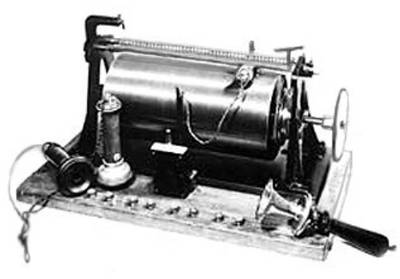

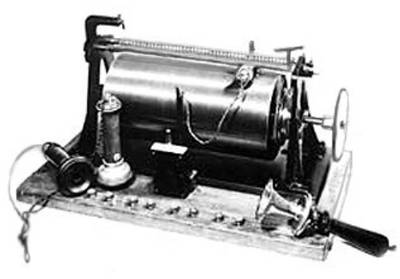

Zasady magnetycznego zapisu informacji opisał w 1888 roku Oberlin Smith. Nie wykonał on jednak eksperymentów. Dopiero wiele lat później zademonstrowano pierwsze urządzenie. W 1898 roku Valdemar Poulsen, duński inżynier zajmujący się telefonią, wynalazł i opatentował telegrafon – urządzenie do zapisu mowy, w którym wykorzystano zjawiska magnetyczne.

Dźwięk był zapisywany w drucie stalowym o średnicy 1mm. Poulsen użył struny fortepianowej. Drut był magnesowany przez elektromagnes, w którym prąd był wzbudzony przez mikrofon telefoniczny.

Telegrafon publicznie zademonstrowano w 1900 roku na Światowej Wystawie w Paryżu. Zarejestrowano na niej nagranie głosu cesarza Franciszka Józefa, które jest przechowywane w Duńskim Muzeum Nauki i Technologii.

W 1927 roku austriacki wynalazca zastąpił taśmę stalową taśmą papierową pokrytą sproszkowanym materiałem magnetycznym.

W 1931 roku w Niemczech rozpoczęto prace nad pierwszym magnetofonem, rejestrującym dźwięk na taśmie magnetycznej w formie zbliżonej do stosowanych obecnie.

Pod koniec II wojny światowej w Niemczech opracowano taśmę celuloidową pokrytą warstwą z granulkami tlenku żelazowego o średnicy rzędu mikrometrów. Taśma magnetofonowa firmy BASF z 1945 roku miała 1000 m długości, 6,5 mm szerokości i pozwalała na nagranie 20 minut dźwięku.

Pierwszy magnetofon stereofoniczny opracowano w 1949 roku. W połowie lat sześćdziesiątych rozpoczęto produkcję magnetofonów wielościeżkowych przeznaczonych dla studiów nagraniowych.

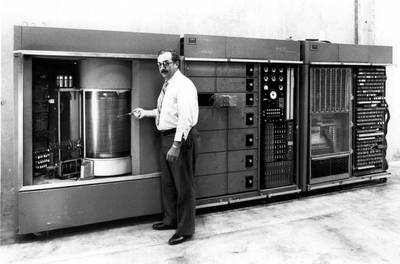

Po raz pierwszy magnetyczną pamięć taśmową do zapisu danych zastosowano w firmie IBM, w której skonstruowano urządzenie IBM 726 współpracujące z komputerem IBM 701 Defense Calculator.

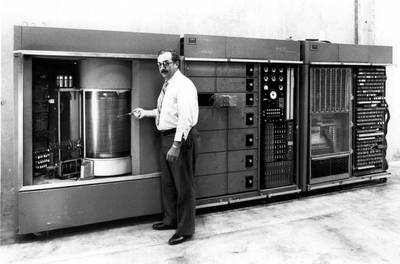

Dyski magnetyczne

Pierwsze konstrukcje cyfrowych pamięci dyskowych powstały w firmie IBM w latach pięćdziesiątych XX wieku. W 1956 roku zbudowano w tej firmie urządzenie o nazwie IBM 350 RAMAC Disk File. Urządzenie to składało się z 50 dwustronnych dysków aluminiowych pokrytych warstwą tlenku żelaza. Dyski o średnicy 61 cm były zamontowane na stałe, a całkowita ich pojemność wynosiła 4,5 MB.

W 1962 roku urządzenie o nazwie IBM 1311 Disk Storage Drive było pierwszym systemem pamięci z wymiennymi pakietami dysków. Pakiet składał się z kilku dysków o łącznej pojemności 2 milionów znaków.

Jednym z protoplastów współczesnych, twardych dysków magnetycznych było urządzenie IBM 3030 opracowane w 1973 roku. System składał się z dwóch zestawów dysków o pojemności 30 MB każdy.

Pierwsze dyski dla komputerów osobistych były urządzeniami umieszczanymi w oddzielnych obudowach, które oprócz dysku zawierały kartę sterownika i własny zasilacz. Jednym z pierwszych modeli był Seagate ST-506 o pojemności 5 MB.

Dyski wymienne

Wymienny dysk magnetyczny jest jednym z prostszych i tańszych nośników danych. Pamięć w postaci wymiennego dysku magnetycznego jako pierwszy opracował i opatentował w latach pięćdziesiątych XX wieku Yoshiro Nakamatsu z Uniwersytetu Tokijskiego. Patent wykupiła i wdrożyła firma IBM.

Pierwsza dyskietka magnetyczna miała średnice 20,32 cm (8 cali) i pojemność nieprzekraczającą 100 kB. W 1973 roku powstały dyskietki jednostronne o pojemności 156 kB. W 1975 roku wymienne dyski stosowane w komputerach PDP 11/45 miały już pojemność 2,4 MB.

W 1976 roku opracowano pierwszy powszechny standard dyskietek o średnicy 5,25 cala. Dyskietki tego typu, miały pojemność 220 kB.

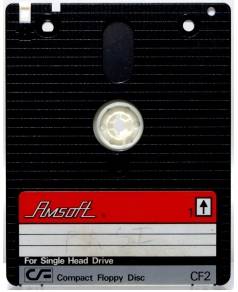

Dyskietka, która zdobyła największą popularność jest dyskietka z politereftalanu etylenu o średnicy 8,89 mm czyli 3,5 cala. Nośnik ten opracowała firma Sony w 1981 roku i początkowo miał pojemność 440 kB. Był stosowany zarówno w komputerach IBM PC, Atari ST, Amiga, jak i w Apple.

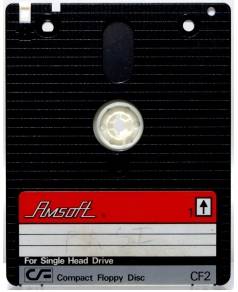

W 1984 roku pojawiły się jeszcze dyskietki 3” początkowo o pojemności 360 kB. Nie zdobyły większej popularności. Wykorzystywane były między innymi w takich komputerach 8-bitowych jak ZX Spectrum i Amstrad.

Pamięć optyczna

Prace nad cyfrową pamięcią optyczną były prowadzone od końca lat sześćdziesiątych XX wieku. W 1968 roku naukowcy z firmy IBM stworzyli doświadczalny system pamięci optycznej z użyciem wiązki lasera. Do dynamicznego rozwoju i upowszechnienia doszło między innymi dzięki opracowaniu technologii produkcji tanich diod laserowych.

W połowie lat osiemdziesiątych były używane cyfrowe płyty optyczne DOR. Płyta DOR pozwalała na przechowywanie około 2 GB informacji. W 1984 roku dostępne były dyski optyczne o średnicy 30,48 cm (12 cali) i pojemności 1 GB.

Dwa lata później pojemność zwiększono do 2 GB. W 1996 roku firma Philips produkowała dwustronne dyski jednokrotnego zapisu o pojemności 12 GB. Optyczne nośniki danych przyjmowały formę nie tylko dysków, ale także pasków umieszczonych na obracających się bębnach.

Jednak technologią, która upowszechniła się na skalę masową, jest technologia Compact Disk opracowana przez firmy Sony i Philips. Jako pierwszy powstał standard dysku dźwiękowego CD-DA zaprezentowany w 1980 roku. W 1985 wprowadzono standard CD-ROM, a następnie w roku 1990 – CD-R i w 1995 CD-RW.

Standardowy dysk CD ma grubość 1,2 mm i średnicę 120 mm lub 80 mm, a gęstość zapisu wynosi około 6,5 MB/cm2.

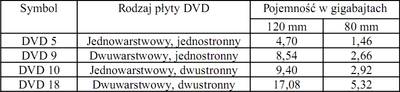

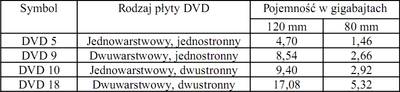

W związku z coraz większymi wymaganiami, stawianymi przez aplikacje multimedialne, możliwości technologii CD stały się niewystarczające. W celu rozwiązania tego problemu opracowano standard płyt DVD.

Zwiększenie pojemności w płytach DVD osiągnięto, stosując kilka udoskonaleń w stosunku do technologii CD. Zachowując te same wymiary zewnętrzne nośnika, zwiększono powierzchnię dostępną do zapisu informacji.

Kolejnym etapem rozwoju są płyty HD-DVD i Blu-ray.

W zapisie i odczycie dysku optycznego pojemność nośnika zależy od średnicy plamki, do jakiej daje się zogniskować wiązkę lasera. Natomiast wielkość plamki zależy od długości fali laserowej. Prace nad nośnikami optycznymi sprowadzają się do poszukiwania technologii stosujących coraz krótsze fale laserowe. W technologii CD stosowano fale podczerwone o długości 780 nm, w DVD – fale czerwone o długości 635 i 650 nm.

W dyskach HD-DVD stosuje się fale o długości 405 nm i układ optyczny z soczewkami o aperaturze 0.65, uzyskując przy tym pojemność użytkową jednej warstwy na poziomie 15 GB. W płytach Blu-ray także stosuje się fale o długości 405 nm, zwiększono aperaturę soczewki do 0,85. Dzięki temu uzyskano 5-krotnie większą pojemność w porównaniu z DVD.

Dysk DVR-Blue, jednostronny, jednowarstwowy ma pojemność 27,4 GB, a dwuwarstwowy – około 50 GB.

Aktualny stan rozwoju nośników optycznych jest podobny do stanu rozwoju nośników magnetycznych. Osiągnięto określoną granice możliwości technologicznych. Tą granicą jest średnica plamki laserowej. Nie oznacza to jednak całkowitego zatrzymania dalszego rozwoju. Do obiecujących kierunków należą: zwiększanie liczby warstw w nośnikach oraz użycie technologii holograficznej. Należy jednak mieć świadomość że znaczenie dysków optycznych maleje na korzyść pamięci półprzewodnikowych (pen drive).

Kierunki rozwoju

Rozwój nośników i systemów przechowywania danych podąża w dwóch ogólnych kierunkach. Po pierwsze doskonalone są istniejące technologie. Po drugie poszukiwane są i badane zupełnie nowe technologie przechowywania danych. Oba kierunki badań dążą do osiągnięcia wielu różnych celów:

W pracach nad nowymi technologiami przechowywania informacji korzysta się z osiągnięć wielu nowoczesnych dyscyplin naukowych i technik, takich jak informatyka kwantowa, spintronika czy mikroelektromechanika. Tak jak w wielu innych dziedzinach, w badaniach nad nowymi technologiami pamięci można zaobserwować coraz większe znaczenie nanotechnologii. Już obecnie niektóre elementy dysków twardych mają wymiary mierzone w dziesiątkach nanometrów. Coraz częściej prowadzi się prace nad pamięciami, w których wymiary komórki czyli pojedynczego elementu pamięci są wyrażane w nanometrach. Wykonuje się także doświadczenia z pamięcią w skali atomowej. Przyszłe pamięci oparte na rozwiązaniach nanotechnologicznych będą charakteryzowały się ogromną gęstością zapisu informacji, a także bardzo małym zapotrzebowaniem na energię.

W pierwszych systemach pamięci atomowej udawało się manipulować pojedynczymi atomami tylko przy bardzo niskich temperaturach. W doświadczeniach, wykonanych w 2002 roku, udało się skonstruować moduł pamięci, w którym do przechowywania bitów w temperaturze pokojowej są używane pojedyncze atomy.

Przewiduje się, że technologia ta pozwoli uzyskać powierzchniową gęstość zapisu dochodzącą do 250 Tbit/cal2. Obecnie do rozwiązania pozostają problemy szybkości zapisu (czyli porządkowania atomów) i błędów odczytu.

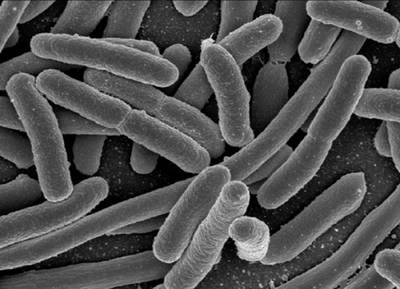

Istnieją także koncepcje zastosowania cząsteczek DNA do przechowywania danych. Proponuje się między innymi stworzenie pamięci optycznej DNA z użyciem zjawiska fluorescencji.

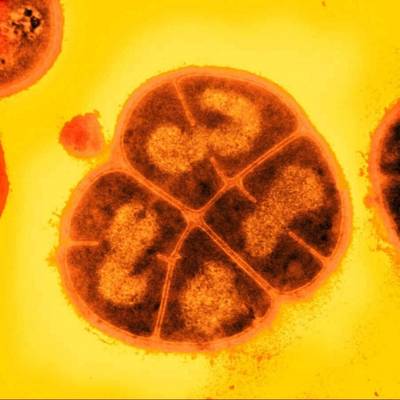

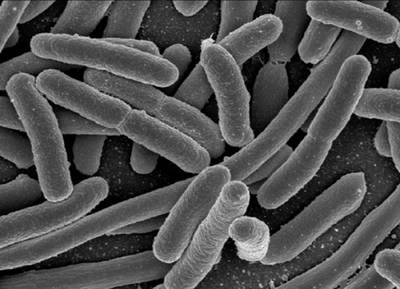

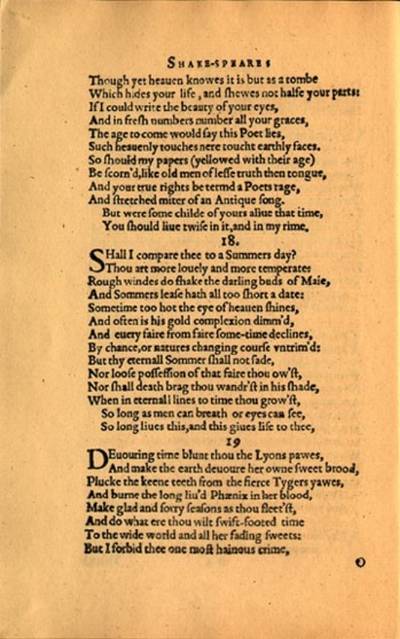

Informacja zakodowana w postaci DNA może być przechowywana w genomie organizmu żywego, na przykład bakterii. W doświadczeniach wykonanych w USA zastosowano w tym celu bakterie Escherichia coli i Deinococcus radiodurans.

Ta druga charakteryzuje się stosunkowo dużą odpornością na niekorzystne warunki zewnętrzne, takie jak wysoka temperatura, promieniowanie ultrafioletowe i jonizujące. Bakteria ta ma zdolność do naprawiania spontanicznych mutacji powstających w kodzie DNA. Aby wprowadzony sztucznie i niosący informacje łańcuch DNA nie był zidentyfikowany jako wirus i zniszczony przez bakterię, na jego końcach umieszczono specjalne znaczniki. Pierwsze doświadczenia zakończone sukcesem wykonano w 2002 roku. Informacja wprowadzona do DNA bakterii była kopiowana przez kolejne pokolenia i udało się poprawnie odczytać po stu pokoleniach.

Gęstość zapisu informacji w cząsteczkach DNA jest rzędu setek PB/mm3 objętości DNA w formie wysuszonej. Fragment ludzkiego DNA o długości około 6 mm i objętości 500 µm2 zawiera 2x10^8 nukleotydów. Jeżeli założymy, że zestaw 3 nukleotydów reprezentuje 1 bajt, to DNA może teoretycznie przechować informacje z gęstością 1 Mbit/µm3.

Trwają także prace nad stosowaniem cząsteczek DNA nie tylko do przechowywania, lecz także do przetwarzania danych. Zaletą koncepcji komputera DNA jest możliwość zrównoleglenia przetwarzania. Przewiduje się zastosowanie komputerów DNA między innymi do rozwiązywania problemów kombinatorycznych oraz w kryptologii.

Pamięć holograficzna

Pomysł stworzenia pamięci holograficznej pojawił się już pod koniec lat sześćdziesiątych XX wieku. Prace doświadczalne podjęto w latach siedemdziesiątych. Jednak dopiero ostatnio postęp technologiczny, miniaturyzacja i obniżenie kosztów produkcji krytycznych elementów pamięci holograficznej, takich jak diody laserowe, przestrzenne modulatory światła, ciekłe kryształy oraz detektory CCD (charge coupled device), usunęły bariery rozwoju i stworzyły perspektywy dla pierwszych rozwiązań komercyjnych. Istotne jest, że jako podzespoły pamięci holograficznej można zastosować wiele tanich i niezawodnych elementów już istniejących. Dobrym przykładem są diody laserowe stosowane obecnie na skalę masową w medycynie, telewizji kablowej, przemyśle poligraficznym, pamięciach optycznych. Koszt elementów pamięci holograficznej przy produkcji masowej szacowano kilka lat temu na kilkaset dolarów.

Przewiduje się że pamięć holograficzna może zastąpić:

Inne kierunki w badaniach nad nowymi rodzajami pamięci:

MODS

Nietypowy sposób zwiększenia pojemności dysku optycznego opracowali fizycy brytyjscy. Zaprojektowany przez nich dwustronny i dwuwarstwowy dysk optyczny MODS (multiplexed optical data storage) ma pojemność sięgającą 1 TB. Na każdej warstwie dysku mieści się 250 GB danych, a więc 10 razy więcej niż w technologii Blu-ray.

Pamięci polimerowe

W kilku ośrodkach na świecie trwają prace nad pamięciami, w których zostaną wykorzystane polimery ciekłokrystaliczne. Nośnik może mieć formę karty, taśmy, dysku. Zapis i odczyt są wykonywane za pomocą jednej lub kilku wiązek laserowych.

Przykładem praktycznego zastosowania polimerów, jako pamięci optycznej, jest Tesa-ROM. Pamięć ma postać paska folii, a użyty w nim materiał powstał w wyniku badań prowadzonych nad polimerami. W doświadczeniach liniowa gęstość zapisu osiągnęła 1 GB na 1 m taśmy.

Pamięć proteinowa

Naukowcy z Syracuse University badali możliwość zastosowania protein światłoczułych odkrytych w bakteriach Halobacterium halobium występujących w słonych bagnach. Proteiny te, bacteriorhodopsin zamieniają energię światła w umożliwiającą metabolizm – bakteria korzysta z fotosyntezy podobnie jak rośliny. Ze względu na odporność na temperaturę i inne czynniki proteiny zawdzięczają molekułom zwanym chromoforami, które przyjmują wykrywalne i przewidywalne stany podczas naświetlania wiązkami światła o różnej długości.

Pamięć zbudowana z protein bR może być kasowana na dwa sposoby: termicznie lub optycznie. Do przechowywania setek megabajtów potrzeba kilku miligramów substancji, którą można uzyskać w wyniku taniego procesu fermentacyjnego.

Pamięci fluorescencyjne

W latach dziewięćdziesiątych XX wieku opracowano koncepcję pamięci fluorescencyjnych. W technologii, którą opracowano na jej podstawie, podczas odczytu korzysta się ze zjawiska fluorescencji, czyli emisji światła. Wzbudzenie materiału będącego nośnikiem następuje po naświetleniu wiązką lasera. Materiał stosowany jako nośnik charakteryzuje się niewielkim współczynnikiem pochłaniania światła, dzięki czemu możliwe jest użycie wielu warstw w jednym bloku pamięci. Przewidywano stworzenie wielu rodzajów nośników, początkowo typu ROM i WORM z pojemnością do 140 GB, w dalszej perspektywie – nośniki do wielokrotnego zapisu z pojemnością większą niż 1 TB.

Pamięć dwufotonowa

W połowie lat dziewięćdziesiątych XX wieku zbudowano pamięć typu WORM, w której wykorzystano zjawisko absorpcji dwóch fotonów. Pamięć tego typu należy do grupy pamięci, w których możliwy jest dostęp równoległy do całej strony danych. Działanie pamięci opiera się na jednoczesnej absorpcji dwóch fotonów, których łączna energia jest równa różnicy między początkowym a końcowym stanem materiału stosowanego jako nośnik.

Pamięci z oddziaływaniami elektrycznymi

Do grupy pamięci używających oddziaływań elektrycznych zaliczymy, luźno ze sobą związane, technologie, w których podczas zapisu/odczytu występuje oddziaływanie na nośnik polem elektrycznym lub wiązką elektronów.

Pamięć elektryczna zmiennofazowa

W pamięciach elektrycznych PCM (phase change memory) informacja jest reprezentowana przez dwa stany różniące się właściwościami elektrycznymi. Nośnikiem danych jest materiał, który istnieje w dwóch stanach fizycznych stabilnych w temperaturze pokojowej: amorficznym i krystalicznym. Przewiduje się możliwość zbudowania pamięci o rozdzielczości atomowej (na 1 punkt nośnika przypada 100 atomów materiału), z gęstością zapisu rzędu terabitów na centymetr kwadratowy.

Pamięć ferroelektryczna

W kilku laboratoriach na świecie trwają prace nad pamięcią ferroelektryczną. W pamięci ferroelektrycznej FeRAM stosuje się materiały, które mogą być elektrycznie polaryzowane. Dodatnie i ujemne ładunki w materiale są separowane i powstaje w ten sposób pole elektryczne z dwoma przeciwnymi polaryzacjami. Pod koniec XX wieku, w warunkach laboratoryjnych, udało się zbudować blok pamięci o długości 1mm zawierający 10000 komórek.

Pamięć elektrostatyczna

Prace nad pamięcią elektrostatyczną są prowadzone na New York State University. Informacja jest przechowywana w formie niewielkiego ładunku elektrycznego (kilka elektronów). Do rozwoju tej technologii przyczyniło się w dużej mierze wynalezienie jednoelektronowego tranzystora. Szacuje się, że gęstość powierzchniowa przekroczy 1 Tbit/cal2.

Pamięć molekularna

W pamięci elektrycznej molekularnej informacja jest przechowywana w postaci ładunku elektrycznego, podobnie jak w pamięci półprzewodnikowej CMOS. Różnica polega na tym, że ładunek jest przechowywany w cząsteczce podobnej do chlorofilu, o średnicy około 1 nm. Ocenia się, iż technologia ta umożliwi co najmniej 10-krotne zwiększenie gęstości zapisu w porównaniu z gęstością w tradycyjnej technologii CMOS.

W doświadczeniach przeprowadzonych w firmie Hewlett Packard w 2005 roku udało się zademonstrować pamięć o pojemności 1 kbit.

Pamięć jednoelektronowa

W połowie lat osiemdziesiątych XX wieku pojawiły się prognozy wskazujące na możliwość sterowania ruchem pojedynczego elektronu. Pierwszy tranzystor przełączany jednym elektronem zaprezentowano w 1987 roku. W laboratoriach NEC Corporation udało się zbudować dwuczęściowy element pamięci. Jedna część działa jako pułapka mogąca wychwytywać pojedyncze elektrony, a drugą częścią jest tranzystor wykrywający istnienie pojedynczego elektronu w pułapce.

MRAM

Pamięć magnetologiczna MRAM (magnetic RAM, magnetoresistive RAM) łączy cechy zewnętrznych pamięci masowych (duża pojemność i brak konieczności dostarczania energii w czasie przechowywania) oraz półprzewodnikowych pamięci operacyjnych.

Komórka pamięci ma budowę wielowarstwową. Jej zasadniczymi elementami są oddzielone od siebie warstwy ferromagnetyczne. Pamięci tego typu mają charakteryzować się bardzo dobrymi parametrami dotyczącymi czasu: czas zapisu ma wynosić 2,3 ns, a czas odczytu 3,0 ns.

Magnetyczne materiały światłoczułe

W USA stworzono przełączany światłem materiał magnetyczny z molekuł organicznych. W doświadczeniach wykonanych w 2002 roku udało się zmienić kierunki ustawienia domen tylko w bardzo niskich temperaturach (około –200C). Trwają prace mające na celu zmianę właściwości materiału, tak by domeny mogły być przełączane w wyższych temperaturach.

Pamięć magnetyczno-białkowa

Jednym z problemów technologii magnetycznych jest to, że cząsteczki materiału magnetycznego mają często nieregularne kształty i nierówne wymiary. Uporządkowanie i ujednolicenie cząsteczek ferromagnetycznych na powierzchni nośnika można osiągnąć, umieszczając je wewnątrz cząsteczek białka o regularnych kształtach. Białkiem nadającym się

do tego celu jest ferrytyna.

Trwałość nośników i urządzeń

Nośniki, a tym samym informacje na nich przechowywane, są podatne na wiele czynników zewnętrznych, takich jak promieniowanie elektromagnetyczne, pole elektrostatyczne, promieniowanie ultrafioletowe, substancje chemiczne, oddziaływania mechaniczne. Wiedza na temat tego, jak długo można bezpiecznie przechowywać dane na nośnikach, jest istotna dla wielu użytkowników: instytucji rządowych, szpitali, banków i innych firm.

Problem trwałości nie jest związany wyłącznie z elektronicznymi nośnikami danych. Dotyczy także nośników tradycyjnych, takich jak papier. Badania z lat pięćdziesiątych XX wieku wykazały na przykład, że papiery wyprodukowane około 1900 roku, po 50 latach straciły około 90% elastyczności i wytrzymałości. Proces starzenia się papieru i pogorszenia właściwości mechanicznych jest związany z polimeryzacją celulozy i hemicelulozy. Na proces ten wpływają szkodliwe czynniki zewnętrzne, takie jak temperatura, wilgotność i zawartość ditlenku siarki w powietrzu.

Ze względu na zastosowane materiały i technologie różne nośniki są podatne na różne czynniki szkodliwe, jednak każdy z nośników ulega stopniowej degradacji w miarę upływu czasu. Czas bezpiecznego przechowywania informacji na nośnikach danych jest ograniczony i nie zawsze pokrywa się z czasem wymaganym. W celu ochrony integralności i dostępności danych należy przestrzegać wielu zaleceń. Między innymi należy korzystać z nośników wysokiej jakości. Nośniki powinny być przechowywane w kontrolowanych warunkach, systematycznie trzeba weryfikować działanie systemu archiwizacji i systemu wykonywania kopii zapasowych, korzystać z mechanizmów zwiększających niezawodność dysków twardych i informujących o możliwości wystąpienia awarii.

Zależność między prawdopodobieństwem wystąpienia awarii a czasem eksploatacji jest podobna we wszystkich urządzeniach, niezależnie od ich przeznaczenia. Kinetykę procesu zmian starzeniowych opisuje model Arheniusa. Zakłada się, że określona bariera energetyczna Ea powstrzymuje korozję, utlenianie i degradację. Wartość tej bariery energetycznej jest w pewnym sensie miarą odporności na oddziaływanie czynników zewnętrznych. Tempo zachodzenia reakcji zależy od dodatkowych czynników, na przykład wilgoci.

Technologia wykonania ma istotny wpływ na podatność nośnika na oddziaływania szkodliwe. Przykładowo, nośniki optyczne i magnetyczne są w różnym stopniu odporne na poszczególne czynniki szkodliwe. Natomiast, jeżeli mamy do czynienia z nośnikami wykonanymi w tej samej technologii, to ich podatność na czynniki szkodliwe zależy od jakości procesu produkcyjnego i jakości surowców użytych do produkcji.

Jakość wyprodukowanego nośnika zależy od producenta, a także od aktualnego stanu linii produkcyjnej. W okresach rozruchowych urządzenia wytwarzające nośniki nie zawsze spełniają normy jakościowe; mówi się wtedy o produkcji nośników typu no name, które mają gorsze parametry od produkowanych w normalnym cyklu produkcyjnym.

Nośnik ulega degradacji z szybkością, która zależy od intensywności eksploatacji. W systemach, w których korzysta się z wielu nośników, obciążenie każdego z nich powinno być mniej więcej równe – w tym celu stosuje się algorytmy rotacji nośników.

Zewnętrznymi czynnikami środowiskowymi stanowiącymi zagrożenie dla nośników danych są:

Nośniki wykonane w różnych technologiach wymagają różnych warunków przechowywania. Za właściwą temperaturę uznaje się zwykle temperaturę w przedziale 17-20 C.

Jednym z czynników prowadzących do degradacji nośników jest duża wilgotność powietrza. W systemach pamięci magnetycznych, w których głowica styka się z powierzchnią nośnika, im wyższa jest wilgotność powietrza, tym szybsze jest tempo zużywania się głowicy. Duża wilgotność powietrza może prowadzić do hydrolizy polimeru.

Szybkość, z jaką to zjawisko zachodzi, jest proporcjonalna do względnej wilgotności powietrza. Nośniki danych powinny być przechowywane w miejscach suchych, by zapobiec kondesacji pary wodnej. Ponadto w celu uniknięcia problemów związanych z kondesacją pary wodnej nośnik, który był przechowywany w chłodnym miejscu, nie powinien być umieszczany w urządzeniu, zanim jego temperatura nie zrówna się z temperaturą otoczenia.

Niektóre rodzaje promieniowania elektromagnetycznego mają charakter szkodliwy. W ciągu sekundy każdy metr kwadratowy atmosfery ziemskiej jest przenikany przez około 100 000 cząstek promieniowania kosmicznego o dużej energii. Wysokoenergetyczne cząstki promieniowania kosmicznego uderzające w układy scalone mogą doprowadzić do przejściowych zakłóceń w działaniu lub trwałych awarii. Przypuszcza się, że awarię strimera w sondzie kosmicznej Galileo spowodowało promieniowanie kosmiczne podczas przejścia sondy przez magnetosferę Jowisza.

Kolejnym szkodliwym czynnikiem są wyładowania elektrostatyczne, które mogą doprowadzić do uszkodzenia układów scalonych. W czasie wyładowania wydziela się duża ilość energii termicznej. Wewnątrz układu scalonego temperatura może osiągnąć 1500 C – w rezultacie następuje stopnienie metalowych połączeń lub wypalenie kanalików w warstwie izolującej. Innym problemem jest przemieszczanie się atomów na skutek dostarczania energii termicznej. Wyładowanie o napięciu kilkudziesięciu kilowoltów może doprowadzić do zniszczenia układu scalonego. Ładunek taki powstaje między innymi w wyniku przejścia człowieka po dywanie.

Taśmy magnetyczne

Taśmy magnetyczne, w których warstwa magnetyczna jest zbudowana z polimeru wiążącego cząsteczki magnetyczne, są narażone na chemiczną degradację . Taśmy, które umożliwiają osiąganie dużych gęstości danych, składają się z materiałów o złożonej budowie cząsteczkowej. Polimer absorbuje wilgoć z otoczenia i ulega hydrolizie, czyli procesowi, w którym pod wpływem wody makrocząsteczki polimeru rozkładają się na krótsze łańcuchy.

Nośniki optyczne

W porównaniu z nośnikami magnetycznymi nośniki optyczne są bardziej odporne na działanie czynników zewnętrznych.

Do błędów odczytu może dojść na skutek zarysowania, zabrudzenia lub odkształcenia dysku. Wewnętrzna warstwa odbijająca jest chroniona przed uszkodzeniami mechanicznymi przez warstwę poliwęglanu. Tylko drobne uszkodzenia jak zarysowania warstwy poliwęglanu o niewielkiej głębokości i zanieczyszczenia na dysku, nieduże w porównaniu ze średnicą wiązki laserowej, nie wpływają na poprawność odczytu.

W dyskach DVD warstwa poliwęglanu ma mniejszą grubość w porównaniu z CD, a więc dyski te są bardziej narażone na uszkodzenia mechaniczne i zmiany wynikające z hydrolizy poliwęglanu. Dyski Blu-ray mają jeszcze mniejszą grubość warstwy poliwęglanu. Problemu degradacji warstwy światłoczułej w dyskach DVD na razie nie zbadano. Warstwa poliwęglanu, stanowiąca podłoże dysku optycznego, jest podatna na stopniową degradację. Pod wpływem wysokiej temperatury i dużej wilgotności poliwęglan ulega hydrolizie. Hydroliza powoduje rozkład makrocząsteczek poliwęglanu na krótsze łańcuchy.

Dysk optyczny jest zbudowany z kilku warstw spojonych ze sobą. Błędy technologiczne w procesie produkcji i nieodpowiednie warunki środowiskowe mogą spowodować rozwarstwienie dysku, co z kolei prowadzi do błędów odczytu. Do rozwarstwienia dochodzi wtedy, kiedy na dysk działa odpowiednio duża siła, na przykład podczas uginania, pisania na powierzchni dysku, przyklejania lub odklejania etykiety.

W tabeli 3 przedstawiono wyniki badań dotyczących wpływu temperatury i wilgotności powietrza na bezpieczeństwo danych przechowywanych na dyskach CD. W badaniach tych założono, że warunki środowiska są stałe i nie uwzględniono wpływu innych szkodliwych czynników.

Dyski optyczne jednokrotnego zapisu zawierają warstwę barwnika zmieniającego właściwości optyczne pod wpływem silnej wiązki laserowej. Problemem jest to, że barwnik ten może utracić swoje właściwości optyczne. Energia dostarczona w postaci promieniowania ultrafioletowego powoduje wyblakniecie barwnika, a tym samym zmniejszenie kontrastu między pitami i landami (pity to zgłębienia na powierzchni dysku powodujące słabsze w stosunku do powierzchni płaskiej (tzw. landów) odbicie promienia laserowego). Wynikiem są błędy odczytu.

Szybkość zachodzenia tego procesu zależy od natężenia promieniowania i rodzaju zastosowanego barwnika. Z uwagi na to najgorsze parametry mają dyski z barwnikiem cyjaninowym.

Co ciekawe płyty kompaktowe mogą zostać zaatakowane także przez grzyby, np. Geotrichum-candidum.

Aby wydłużyć życie płyt CD i DVD:

Pamięć flash

Pamięć flash jest pamięcią półprzewodnikową wykonaną w technologii EEPROM. Zapis i odczyt danych odbywa się z użyciem prądu elektrycznego, natomiast informacja jest reprezentowana przez ładunek elektryczny uwięziony wewnątrz tranzystora polowego. Pamięć tego typu jest odporna na oddziaływanie pól magnetycznych, promieniowania ultrafioletowego i wysokiej temperatury. O jej dużej odporności może świadczyć to, że zastosowano ją w teleskopie Hubble’a do tymczasowego przechowywania danych przed wysłaniem ich do stacji naziemnej. Badania, wykonane w 2004 roku wykazały, że karty pamięci flash są odporne na promieniowanie X używane w skanerach do kontroli bagażu. Czynnikiem stanowiącym zagrożenie dla pamięci półprzewodnikowej jest pole elektrostatyczne. Typowe karty pamięci flash nie są wytrzymałe na pola elektrostatyczne o wartkości większej niż 15kV.

Średni czas międzyawaryjny

Średni czas międzyawaryjny, MTBF (mean time between failures) jest parametrem najczęściej podawanym w specyfikacjach urządzeń. MTBF danego urządzenia jest definiowany jako iloraz całkowitego czasu pracy dużego zbioru identycznych urządzeń do liczby awarii, które wystąpiły w tym czasie MTBF = T/A, gdzie: T całkowity czas pracy grupy urządzeń, A – liczba awarii w czasie pracy, przy czym zakłada się, że po wystąpieniu awarii urządzenie jest naprawiane, a po naprawie dalej eksploatowane.

MTBF jest definiowany dla zalecanej temperatury pracy. Szacuje się natomiast, że prawdopodobieństwo wystąpienia awarii zwiększa się o 2-3% wraz ze wzrostem temperatury pracy o 1C. Przykładowo, dysk pracujący przez dłuższy czas w temperaturze o 5C wyższej od zalecanej będzie miał o 10-15% wyższą stopę błędów. Z kolei praca w temperaturze niższej od zalecanej spowoduje zmniejszenie stopy błędów.

Produkowane w ostatnich latach dyski twarde mają MTBF od kilkuset do ponad miliona godzin. Najwyższe wartości MTBF, dochodzące do 2.000.000 h, mają tzw. dyski półprzewodnikowe, w których pliki są zapisane w półprzewodnikowej pamięci EEPROM, a urządzenie nie zawiera elementów mechanicznych. Współczynnik MTBF nie nadaje się do prognozowania czasu, w którym dojdzie do awarii konkretnego urządzenia. Wartość tego parametru nie jest wyznacznikiem trwałości pojedynczego urządzenia. Ze stwierdzenia, że dysk twardy ma MTBF = 2.000.000 h wcale nie wynika, że konkretny egzemplarz takiego dysku będzie pracował bez awarii przez 2.000.000 godzin. Wartość ta pozwala jedynie oszacować liczbę awarii, które mogą wystąpić w systemie zawierającym wiele takich dysków.

Problemy z jakimi mogą spotkać się przyszłe pokolenia przy archiwizacji danych

Dokument tradycyjny można odczytywać bez specjalnych urządzeń, narzędzi lub wiedzy poza znajomością języka, w którym został napisany. Dokumenty cyfrowe można w nieskończoność kopiować (również na podstawie kolejnych kopii) bez uszczerbku na jakości, dlatego często sławi się ich długowieczność. Tymczasem za 50 czy 100 lat ciągła ewolucja sprzętu komputerowego i oprogramowania sprawi, że bez kłopotu odczytamy jedynie zwykły, papierowy tekst.

Już kilka razy o mało nie doszło do katastrofy. W raporcie Izby Reprezentantów USA z 1990 roku można przeczytać o tym, jak dokumentacja spisu ludności przeprowadzonego 30 lat wcześniej cudem uniknęła zniszczenia. Taśmy, na których zapisano dane, zestarzały się (w wyniku modernizacji formatów) szybciej, niż sądzono. Na szczęście większość informacji zdołano przenieść na nowe nośniki. W raporcie odnotowano także inne niedoszłe nieszczęścia związane m.in. z taśmami amerykańskiego Departamentu Zdrowia i Opieki Społecznej oraz ze zbiorami należącymi do różnych agencji rządowych, w tym do komisji zajmującej się problemem narkomanii i do komisji analizującej prawo ziemskie. Zagrożone były zbiory informacji o amerykańskich żołnierzach wziętych do niewoli i zaginionych w akcji w Wietnamie, a także dane umożliwiające ocenę zniszczeń dokonanych przez herbicydy. W niebezpieczeństwie są również naukowe bazy danych. Starzeją się unikalne zapisy wielu eksperymentów przeprowadzonych przez NASA i inne instytucje; grozi im „odejście w niepamięć”.

Tylko 20% firm w Wielkiej Brytanii posiada strategię ochrony archiwów cyfrowych - wynika z raportu Digital Preservation Coalition. Cyfrowe archiwa są bardzo nietrwałe, a ich brak może dużo kosztować.

Sondaż wykazał, że utrata danych zapisanych w postaci cyfrowej należy do zdarzeń powszechnych. Ponad 70% ankietowanych firm doświadczyło takiego zdarzenia. Świadomość zagrożeń natury ekonomicznej, jakie wiążą się z utratą danych cyfrowych jest duża: 87% ankietowanych zdaje sobie sprawę, że stracić może istotne zasoby firmowej pamięci albo zasoby istotne dla kultury organizacyjnej. Około 60% uważa, że w związku z takim wydarzeniem, firma może stracić finansowo. 52% firm dostrzega potrzebę zarządzania archiwami cyfrowymi, ale jednocześnie tylko co piąta firma dysponuje spójną strategią dotyczącą archiwów cyfrowych.

O tym, jak wiele może kosztować niedbałość lub brak szczęścia przekonał się w ostatnim czasie bank Morgan Stanley. Będzie on zmuszony wypłacić ponad miliard dolarów, ponieważ nie potrafił dostarczyć na rozprawę z byłym klientem archiwów poczty elektronicznej sięgających początków lat 90. Amerykańska Komisja Papierów Wartościowych i Giełd (SEC) dodatkowo ukarze bank za niedotrzymanie procedur zachowywania dokumentów w poczcie elektronicznej kwotą 10 mln dolarów.

Przykładów na nietrwałe archiwa cyfrowe jest więcej. Niedawno odkryto, że pomimo bardzo starannego przechowywania, taśmy z danymi z misji Viking Lander na Marsa uległy częściowemu zniszczeniu. Okazało się ponadto, że nie da się odkodować formatów zapisu danych i obecnie można polegać tylko na archiwalnych papierowych wydrukach tych danych. Jak krucha jest pamięć zapisana elektronicznie dowodzi jeszcze jeden przykład. W 1986 roku w Wielkiej Brytanii stworzono cyfrową kapsułę czasu: na 30 cm dysku laserowym zapisano fotografie ulic miast brytyjskich z danego dnia, mapy, dane statystyczne itd. Niespełna 20 lat po zamknięciu kapsuły okazało się, że format danych jest przestarzały. Zapis udało się odczytać po rocznej pracy zespołu specjalistów dzięki temu, że przetrwał odtwarzacz. Wartość wielu dokumentów cyfrowych tych, które dzisiaj nie wydają się zasługiwać na archiwizację – może okazać się bezcenna wówczas, gdy już nie będą czytelne. Tradycyjne metody przechowywania dokumentów drukowanych są nieprzydatne w przypadku zbiorów komputerowych. Treść i wartość historyczna tysięcy zapisków, baz danych i osobistych dokumentów może być bezpowrotnie stracona, jeżeli dzisiaj nie podejmiemy starań o ich zachowanie.

Dane cyfrowe teoretycznie nie poddają się niszczącemu działaniu czasu. Jednak fizycznych nośników, na których zapisujemy, na pewno nie można uważać za niezniszczalne. Gdybyśmy zostawili na dłuższy czas dysk magnetyczny, wówczas próby jego odczytania byłyby przypuszczalnie z góry skazane na niepowodzenie. Rozproszone pola magnetyczne i erozja materiału (zwłaszcza wpływ czynników utleniających) mogą łatwo doprowadzić do skasowania zapisu. Zawartość większości komputerowych nośników znika szybciej niż słowa zapisane na papierze dobrej jakości. Zanim zniknie, staje się z reguły rażąco przestarzały w miarę wprowadzania nowych, „niekompatybilnych” ze sobą standardów. Wcale nie jest niepoważne stwierdzenie, że informacje cyfrowe przetrwają wiecznie lub przez 5 lat – w zależności od tego, co nastąpi szybciej.

Jednak ani fizyczna nietrwałość mediów używanych do zapisu danych, ani ich nieuchronna dezaktualizacja nie będą największym problemem przyszłych pokoleń. Ich zadanie polegać ma nie tylko na odczytaniu zawartości dysku, ale i na prawidłowej interpretacji zapisu.

Aby zrozumieć te sprawy, musimy wniknąć w istotę cyfrowego zapisu informacji. Komputerowe dane można przechowywać na każdym nośniku zdolnym do reprezentacji dwójkowych cyfr (bitów) 0 i 1. Każdą zamierzoną, niosącą informację sekwencję zer i jedynek, nie zakłóconą przerwami (spacjami), znakami przestankowymi lub formatowaniem będziemy nazywali strumieniem bitów. Do odzyskiwania zapisanego strumienia bitów potrzebne są specjalne urządzenia, takie jak czytnik dyskietek, oraz układy elektroniczne rozszyfrujące fizyczną reprezentację bitów na nośniku. Aby zapewnić współpracę tych urządzeń z komputerem, niezbędny jest też tzw. Program obsługi (driver). Uzyskany ciąg zer i jedynek należy jeszcze zinterpretować.

Nie jest to zadanie trywialne, jako że w danym strumieniu bitów kryć się może niemal wszystko – od sekwencji liczb całkowitych po tablicę punktów zdjęcia. Co więcej, prawidłowa interpretacja strumienia bitów nie jest możliwa bez zrozumienia jego przypuszczalnej struktury, tej zaś nie można przedstawić w sposób jawny. Strumień bitów reprezentujących ciąg liter alfabetu może składać się z segmentów o stałej długości (bajtów). Wówczas służą one do zapisu kodów właściwych poszczególnym literom. Na przykład według jednego z używanych dzisiaj (UTF-8) schematów zapisu osiem bitów: 01000101 oznacza literę E. A zatem, chcąc dokonać odczytu strumienia bitów, musimy znać konwencję określającą długość bajta.

Jednym ze sposobów przekazania tej wiadomości jest zakodowanie jej w postaci klucza umieszczonego na początku strumienia bitów. Jednak sam klucz także musi być reprezentowany przez bajt pewnej długości. Przyszły czytelnik nie poradziłby więc sobie bez kolejnego klucza – mającego posłużyć do rozszyfrowania pierwszego. Rozwiązaniem tego rekurencyjnego problemu jest tzw. inicjowanie początkowe. W tym przypadku inicjacja polegać musi na dostarczeniu wskazówek – możliwych do odczytania przez człowieka – dotyczących sposobu interpretacji zapisu cyfrowego.

Po prawidłowym wyłowieniu bajtów ze strumienia bitów staniemy przed następnym problemem. Bajt reprezentować może liczbę lub kod znaku alfanumerycznego. W tym ostatnim przypadku musimy znać schemat kodowania, którego identyfikator moglibyśmy umieścić w naszym strumieniu. Niestety, do odczytywania identyfikatora niezbędny jest schemat kodowania. Znowu więc nie sposób obejść się bez inicjowania początkowego – w formie możliwej do odczytania bezpośrednio przez człowieka.

Jeżeli przyszłe pokolenia poradzą sobie z odczytaniem strumienia bitów zapisanego na płycie DVD staną przed głównym problemem: interpretacji przekazu zakodowanego w strumieniu. Większość zbiorów komputerowych zawiera treści, których pełne odtworzenie możliwe jest wyłącznie po zastosowaniu oprogramowania użytego niegdyś przy ich tworzeniu. W zbiorach sporządzanych za pomocą procesorów tekstu obecne są instrukcje dotyczące detali typograficznych, wyglądu poszczególnych stron, organizacji rozdziałów dokumentu, tytułów itd. Z kolei w zbiorach tworzonych za pomocą arkuszy kalkulacyjnych ukryte są wzory opisujące matematyczne relacje pomiędzy poszczególnymi komórkami. Natomiast zbiory zwane hipermedialnymi muszą zapierać informacje umożliwiające rozpoznawanie oraz wzajemne kojarzenie danych tekstowych, graficznych, dźwiękowych i synchronizujących.

Prawidłowe odtworzenie dokumentu możliwe jest za pośrednictwem oprogramowania, za pomocą którego powstał. Jeśli takiego (lub równorzędnego) oprogramowania nie mamy, wówczas dokument pozostanie jedynie zakładnikiem własnego kodu.

Metoda prób i błędów może okazać się skuteczna przy interpretacji dokumentu stanowiącego ciąg znaków. Takie brutalne podejście zawiedzie jednak w obliczu dokumentów złożonych. Zawarty w zbiorze sens nie jest związany z samymi bitami, podobnie jak znaczenie zdania nie tkwi wyłącznie w słowach. Aby zrozumieć dowolny dokument, musimy znać język czytelnika, do którego został zaadresowany. Niestety, owym domyślnym czytelnikiem dokumentu cyfrowego jest wyspecjalizowany program – bez niego zbiory w rodzaju prezentacji multimedialnych stają się bezwartościowe. Widać tu wielką przewagę tradycyjnych treści drukowanych.

W niektórych przypadkach programy zbliżone poradzą sobie z częściowym przynajmniej odczytem naszego zbioru. Naiwnością byłoby jednak oczekiwać, że określony system kodowania – nawet taki, który jawi się dziś jako zupełnie naturalny – wytrzyma próbę czasu. Informatycy ciągle opracowują nowe schematy zapisu danych, oznaczające często konieczność rezygnacji z dotychczasowych metod.

Dobrym przykładem są tu edytory tekstu. Większość z nich pozwala autorowi zapisać dzieło w formie zwykłego tekstu, z użyciem 7-bitowego kodu ASCII (American Standard Code for Information Interchange). Tekst taki można by stosunkowo łatwo odczytać w przyszłości, jeśli wspomniany kod zachowałby uprzywilejowaną pozycję. ASCII nie jest jednak wcale jedynym standardem.

Przyszli czytelnicy starych dokumentów cyfrowych mogą zatem stracić szansę odgadnięcia standardu kodowania. Sytuacje dodatkowo komplikuje fakt, że autorzy rzadko korzystają z możliwości zapisu swojej pracy w formie czystego tekstu.

Jeśli przez odczytanie dokumentu rozumiemy tylko wydobycie jego zawartości – bez początkowej formy – wówczas użycie oryginalnego oprogramowania nie jest konieczne.

Postępując tak, ryzykujemy jednak utratę lub przemieszczenie fragmentów treści ukrytej w przykładach w nagłówkach, tytułach lub przypisach (jest to częsty efekt uboczny tłumaczenia jednych standardów edycji tekstów na inne).

Czy za 50 lat przyszłe pokolenia będą miały szansę znaleźć stosowane przez nas programy? Można zamieścić na płycie DVD czy innym nośniku kopię edytora tekstu. Wówczas jednak pozostanie problem dostępności oprogramowania systemowego umożliwiającego uruchomienie owego edytora. Pomocne mogłoby się okazać wzbogacenie zawartości dysku o kopię systemu operacyjnego. Lecz przecież sprzęt komputerowy związany z tym systemem dawno już wyjdzie z użycia jako przestarzały technologicznie.

Działania zmierzające do ocalenia dokumentów cyfrowych powinniśmy zaczynać od ochrony odpowiednich strumieni bitów. Oznacza to konieczność ciągłego kopiowania danego zbioru na nowe rodzaje nośników w celu zachowania jego czytelności. Nasuwa się porównanie z przepisywaniem praktykowanym kiedyś w celu zachowania tradycyjnego tekstu. Oba działania mają długofalowy charakter, dostępność dokumentu w przyszłości wymaga nieprzerwanego łańcucha kolejnych wędrówek zapisanej treści. Musi to następować zanim dokument przestanie być czytelny wskutek fizycznego zniszczenia lub przestarzałości technicznej. Najmniejsza przerwa w łańcuchu oznacza utratę informacji, mimo wcześniejszych wysiłków. Współczesne nośniki zapisu cyfrowego charakteryzują się nietrwałością, jednocześnie bardzo szybko ewoluują technicznie – oznacza to konieczność kopiowania archiwów co kilka lat. Najsurowsze normy nakazują nawet coroczne kopiowanie taśm magnetycznych.

Należy sądzić, że potrzeba ciągłego kopiowania danych stanie się w przyszłości mniej paląca dzięki nowym generacjom trwalszych nośników. Produktów takich jeszcze nie widać. Olbrzymie koszty nieustannego przenoszenia zbiorów powinny jednak powściągnąć nasz apetyt na lepszą jakość zapisu cyfrowego; musimy sprawić, by właśnie trwałość była najbardziej poszukiwaną cechą nośników danych.

Starodawny tekst możemy zachować dla potomności, tłumacząc go na język współczesny bądź też kopiując wersję oryginalną. Tłumaczenie wydaje się prostsze, nie wymaga bowiem od kolejnych pokoleń znajomości historii języka. Nie znajdziemy jednak filologa zadowolonego z przekładów swoich poprzedników. Tłumaczenie to nie tylko utrata informacji, ale na dodatek zatarcie śladów po ewentualnych ubytkach, jako że oryginał przestaje istnieć. Wierne kopiowanie tekstu gwarantuje przechowanie treści bez uszczerbku, pod warunkiem że nie zatracimy zdolności rozumienia dawnego języka.

W archiwizacji dokumentów cyfrowych rozróżnia się dwie analogiczne strategie. Pierwszą z nich jest tłumaczenie dokumentu na formę standardową, niezależną od systemu komputerowego. Strategia druga polega na przedłużeniu czasu stosowania danego systemu i współpracującego z nim oprogramowania, które umożliwia odczytanie starych dokumentów. Niestety, obie strategie mają poważne ograniczenia.

Żaden z podstawowych rodzajów oprogramowania nie jest dziś gotowy do standaryzacji. Nie ma powszechnie akceptowanego, formalnego modelu obrazującego sposób przetwarzania informacji przez człowieka. Za wcześnie zatem na wyliczanie najważniejszych programów użytkowych i określanie ich zgodności ze standardami.

Daremne byłby jednak próby sprowadzenia wszystkich dokumentów cyfrowych do wspólnego mianownika, jakim jest sam tekst, i narzucenia użytkownikom niewygód związanych z taką standaryzacją. Siłą napędową rewolucji informatycznej jest przecież właśnie atrakcyjność oferowanych przez nią nowych narzędzi. Określenie długoterminowych standardów dla dokumentów cyfrowych to cel, którego realizacja jest jeszcze odległa - najpierw należy oprzeć informatykę na solidniejszych podstawach formalnych.

Tłumaczenie dokumentów na „dialekty” zgodne z kolejnymi standardami jest pozornie dobrym rozwiązaniem – nie zmusza do wprowadzania jednego, absolutnego standardu. Każdy z przykładów oznacza jednak utratę jakichś informacji. Czy wartość literacka współczesnej wersji "Iliady" Homera nie zostałaby zdeprecjonowana, gdyby tłumaczenie jej oparto nie na najstarszych zachowanych tekstach starogreckich, lecz na kolejnych przekładach pośrednich z języków nowożytnych? Tłumaczenie „do tyłu”, korzystające z wcześniejszych wersji, mogłoby – teoretycznie – umożliwić filologom rekonstrukcję oryginalnego tekstu. Jednak w praktyce postępowanie takie przyniosłoby straty i przekłamania, gdyż tłumaczenie

zazwyczaj nie jest procesem odwracalnym.

Języki takie jak angielski lub grecki (o zbliżonej sile ekspresji i bogactwie semantycznym) zasadniczo różnią się od języków zapisu dokumentów cyfrowych. Te ostatnie bardzo szybko ewoluują, co nieuchronnie prowadzi do częstych modyfikacji formy dokumentów. Oznacza to poważne trudności przy tłumaczeniu, ponieważ nowe formaty (sposoby prezentacji danych) niekoniecznie zachowują zgodność ze starymi. Nie zawsze możliwa jest poprawna konwersja starych dokumentów na aktualne, poprzednio nie znane formaty, często niewykonalne się staje przetłumaczenie współczesnego zbioru na format stosowany dawniej. Na przykład wiele starszych, hierarchicznych baz danych trzeba było całkowicie przeredagować, aby uzyskać zgodność z modelem relacyjnym – tak jak obecnie zmienia się bazy relacyjne w celu dopasowania ich do modeli zorientowanych obiektowo. Problem ten utrudnia - lub wręcz uniemożliwia - nadanie starym dokumentom postaci zgodnej z nowymi standardami.

Zamiast męczyć się z przekładaniem, można by obejrzeć stary dokument za pomocą programu, który niegdyś wykorzystano do jego tworzenia. Nasi potomkowie teoretycznie nie będą musieli nawet uruchamiać dawnego oprogramowania, jeżeli dziś opiszemy jego działanie w sposób niezależny od konkretnego sprzętu komputerowego. Nie jest to jednak możliwe obecnie i zapewne nie będzie w najbliższej przyszłości; współczesna informatyka nie pozwala wyczerpująco opisać działania programów. Jedynym sposobem odtworzenia programu pozostaje zatem jego uruchomienie.

Musimy więc przechowywać zarówno programy, które służyły do sporządzania dokumentów cyfrowych, jak i całe towarzyszące im oprogramowanie systemowe. Zadanie to, choć ogromne, wydaje się wykonalne. Autorzy często załączają odpowiednie programy aplikacyjne i systemy operacyjne do dokumentów, aby ułatwić odbiorcom ich odczytanie. Część tego oprogramowania może w przyszłości pozostać dostępna - wystarczą wówczas odpowiednie informacje załączone przez autora. Bezpłatne programy rozpowszechniane są za pośrednictwem Internetu. Co więcej, przyszli użytkownicy przestarzałego formowego oprogramowania mogą liczyć na wygaśnięcie praw autorskich.

Czy potrafimy zapewnić przetrwanie sprzętu niezbędnego do uruchomienia archaicznych systemów operacyjnych i programów użytkowych? Istnieje kilka wyspecjalizowanych muzeów i klubów retro stawiających sobie za cel utrzymanie staroświeckich komputerów „na chodzie”. Jednak działania takie, choć nie pozbawione uroku, wydają się odmianą donkiszoterii. Popyt na żaden anachroniczny komputer nie będzie tak duży, aby usprawiedliwić ciągłe wydatki na jego reperacje, wymianę zużytych podzespołów i zachowanie związanej z tym wiedzy.

Specjaliści tworzą na szczęście tzw. emulatory. Są to programy, które po uruchomieniu na określonym komputerze naśladują sposób działania innej maszyny, na przykład starszej. Komputery przyszłości powinny mieć znacznie większą moc obliczeniową niż współczesne; można zatem oczekiwać, że będą „emulować” dowolny przestarzały system sprzętowy. Jedyny kłopot to potrzeba przechowywania szczegółowej dokumentacji - sporządzonej w formie czytelnej dla przyszłych pokoleń, a więc niezależnej od jakiegokolwiek oprogramowania.

Przemieszczanie zbiorów zawierających cyfrowe dokumenty i ich macierzyste programy odbywać się musi w sposób gwarantujący nienaruszalność odpowiednich strumieni bitów – najmniejsze zmiany prowadziłyby do zniekształcenia zapisu. Czasami nie można uniknąć pewnych modyfikacji. Powinny one jednak mieć charakter odwracalny – bez straty informacji. Co więcej, należy szczegółowo notować parametry każdej transformacji, aby nie tracić szansy na odtworzenie pierwotnego schematu kodowania. Wyobrażalny jest obecnie taki zapis strumienia bitów, który da mu odporność na wszystkie dające się przewidzieć zmiany; przyszłość może jednak przynieść nowe, trudne do odgadnięcia modyfikacje. Niewykluczone na przykład, że brutalna kompresja danych przekształci strumień bitów w jego przybliżoną kopię pozbawioną kompletu informacji niezbędnych do odtworzenia oryginału. Podobnie proces szyfrowania wymaga znajomości specjalnego klucza.

Idealnym rozwiązaniem byłoby opakowanie nie zakłóconego ciągu bitów w „wirtualną paczkę”, czyli zbiór informacji na temat struktury strumienia i historii jego dotychczasowych przeobrażeń. Wprawdzie na samą paczkę, aby zapewnić jej trwałość, również składałyby się dane cyfrowe; sposób ich kodowania powinien być jednak jak najprostszy, jeśli mają posłużyć do inicjowania. Wynika stąd potrzeba przyjęcia standardów kodowania informacji opisowych; wystarczy prosty system obejmujący wyłącznie dane tekstowe. Każde przenoszenie strumienia bitów na nowy nośnik powinno iść w parze z tłumaczeniem informacji opisowych, czyli być zgodne z aktualnym standardem inicjowania początkowego.

Zakończenie

Tylko nieliczne rządy czy instytucje zdają sobie sprawę z powagi sytuacji i zadbały o trwalsze zabezpieczenie państwowych dokumentów. Rząd francuski np. już od czterech lat wykorzystuje do digitalizacji archiwów płyty wykonywane na zamówienie. Niedawno na podobny krok zdecydowali się Czesi, którzy prócz tego stworzyli optymalne warunki dla przechowywanego sprzętu i nośników. Dobrym przykładem jest także rosyjski Teatr Balszoj i mediolańska La Scala, które zgromadziły swój kulturalny dorobek na nośnikach CD o podwyższonej trwałości.

Tymczasem w 2006 roku ZUS ogłosił przetarg na nośniki do przechowywania naszych danych o emeryturach. W przetargu zawarto dwa główne warunki – niską cenę za płytę i to, że mają być one nagrywane z maksymalną prędkości 24x. Takich krążków już wtedy nie produkowano od ponad trzech lat. Firma, która zaoferowała ZUS-owi te nośniki, musiała je magazynować przez ponad 3 lata. W tym czasie barwnik biorący udział w procesie nagrywania, mógł poważnie się zniszczyć. To może oznaczać, że ZUS szykuje milionom przyszłych emerytów przykrą niespodziankę: gdy z ich elektronicznych archiwów wyparują dane. Dodatkowo w 2008 roku ZUS ogłosił przetarg na 130 tysięcy dyskietek 3,5”.

Szczegóły zamówienia (fragment): "1.Przedmiotem zamówienia jest zakup i dostawa 130.000 szt. dyskietek komputerowych 3,5" o pojemności 1,44 MB, dwustronnych o dużej gęstości, fabrycznie nowych, tj. wyprodukowanych w 2008 roku. 2.Dyskietki muszą być wolne od wirusów, fabrycznie formatowane w formacie IBM PC oraz pakowane w plastikowe pudełka po 10 dyskietek w pudełku. Do każdego pudełka należy dołączyć komplet (min. 10 szt.) naklejek do opisywania zawartości dyskietek. 3. W zakres przedmiotu zamówienia wchodzi również transport zamawianych dyskietek do magazynu, wraz z ich rozładunkiem i ułożeniem we wskazanym przez Zamawiającego miejscu. 4. Dyskietki winny być objęte dwunastomiesięcznym okresem gwarancji, na warunkach zawartych we wzorze umowy. 5. Nie dopuszcza się możliwości składania ofert częściowych."

Należy więc z dystansem traktować cyfrowych rewolucjonistów z ich hasłami „cyfrowe jest lepsze” czy „tylko digitalne ma przyszłość”. Całkowita wirtualizacja wymiany i archiwizacji wszelkiej informacji może bowiem doprowadzić do cyfrowej choroby Alzheimera – do utraty społecznej, kulturowej pamięci.

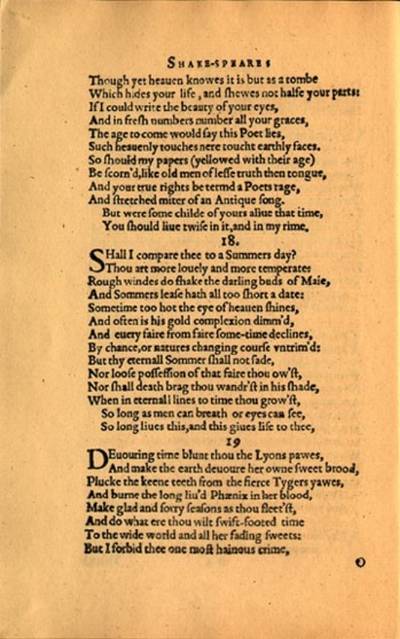

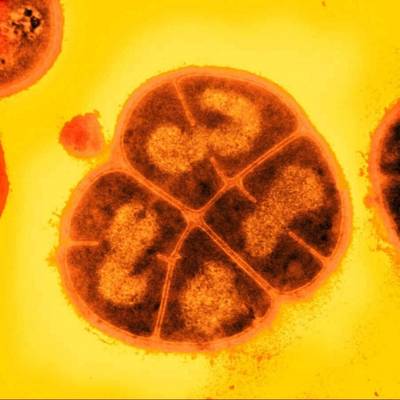

Pierwsze drukowane wydanie 18 sonetu Szekspira (1609) to dowód trwałości tej formy zapisu. Dane z nośników cyfrowych mogą stracić czytelność w ciągu jednego dziesięciolecia, podczas gdy słowa na reprodukowanym dokumencie są wyraźnie widoczne po prawie czterech wiekach. W końcowym dwuwierszu można dopatrzyć się aluzji do treści mojego referatu: "Póki ma ludzkość wzrok, a w piersi tchnienie,/ Będzie żył wiersz ten, a w nim twe istnienie".

So long as men can breath or eyes can see,

So long lives this, and this gives life to thee.

Literatura

• Adleman L., Computing with DNA, Scientific American, 1998.

http://www.usc.edu/dept/molecular-science/fp-scian98.pdf

• Atkinson R., Shiffrin R., , vol 2, Human memory: A proposed system and its control processes, The psychology of learning and motivation: Advances in research and theory Academic Press, 1968.

• Bekenstein J. D., Informacja o holograficznym wszechświecie, „Świat Nauki”, 9/2—3, s. 26-33.

• Bilski T., Digital and Biological Storage Systems –a Quantitative Comparison, W: BIONETICS, 2nd International Conference on Bio-Inspired Models of Network, Information, and computing Systems, Budapeszt, IEEE, 2007.

• Black E., IBM i holocaust, MUZA S.A., Warszawa, 2001.

• Chustecki J., Wirtualizacja pamięci masowych, „NetWorld”, 7/2002, s.56-58.

• Daniel E. D., Mee C. D., Clark M. H., Magnetic Recording. The First 100 Years, IEEE Press, New York, 1998.

• Dembowski K., Warsztat komputerowy, Robomatic, Wrocław 1996.

• Madej J. Sysło M. M., Początki informatyki w Polsce, „Informatyka”, 9/2000, s. 14-19.

• Metzger P., Anatomia PC, Helion, 1996.

• Mochnacki W., Kody korekcyjne i kryptografia, Oficyna Wydawnicza Politechniki Wrocławskiej, Wrocław 2000.

• Tomasz B., Pamięć nośniki i systemy przechowywania danych, WNT, Warszawa 2008.

• Stokłosa J., Bilski T., Panowski T., Bezpieczeństwo danych w systemach informatycznych, PWN, Poznań 2001.

Trwałość dokumentów cyfrowych na tle nośników tradycyjnych

Salvador Dali "Trwałość pamięci" (hiszp. "La

persistencia de la memoria").

Salvador Dali tak właśnie przedstawił w swoim obrazie upływ czasu i jego wpływ na przedmioty materialne. Odporność nośników danych na procesy starzenia jest ważnym problemem współczesnej cyfrowej archiwistyki i informatyki. Konwencjonalne nośniki, takie jak np. papier i cyfrowe nośniki danych, są prawdziwą pamięcią naszej cywilizacji, a ich zniszczenie może spowodować potężny kryzys w skali całego świata.

Cyfrowe nośniki danych starzeją się bardzo szybko, mimo tego że zapisane na nich dane nie poddają się teoretycznie niszczącemu działaniu czasu. Jednak fizycznych nośników, na których je zapisujemy, na pewno nie można uważać za niezniszczalne.

Rewolucja informatyczna coraz intensywniej stara się zastępować papier cyfrowymi nośnikami danych. Cyfrowe wersje dokumentów możemy jednak bezpowrotnie stracić, jeśli nie będą podejmowane odpowiednie działania zaradcze.

Cyfrowe nośniki danych nie oddziałują bezpośrednio na zmysły człowieka, tak jak chociażby znaleziony w 1799 roku w czasie wyprawy Napoleona bazaltowy dokument, sporządzony w klasycznej grece oraz w transkrypcji hieroglificznej.

Pozostaje zadać sobie pytanie, czy następne pokolenia będą miały szansę na odczytanie „nowoczesnych”, zdigitalizowanych zasobów archiwów.

Kamień z Rosetty w British Muzeum. W 1822

odczytano dzięki niemu egipskie hieroglify.

Człowiek od wieków przechowuje informacje zapisywane na wielu różnych, trwałych nośnikach. Należą do nich: kamienie, tabliczki z wypalonej gliny, płytki metalowe, drewno, kora, liście, jedwab i inne tkaniny, sznurek, kości, skorupy żółwi, muszle, skóra, pergamin, papier, papirus, szkło, skały, ściany i mury budowli.

Spośród wymienionych nośników największe znaczenie ma niewątpliwie papier, który zaczęto wytwarzać w Chinach w II wieku n.e. Papierowy nośnik informacji może mieć formę pojedynczej kartki, zwoju lub książki. Znalezienie informacji zapisanej na zwoju wymaga dłuższego czasu niż w książce, którą można otworzyć w dowolnym miejscu. Papier charakteryzuje się dość dużą trwałością, dlatego też w języku angielskim wydruk na papierze to hard copy – czyli kopia trwała. Początkowo informacja na papierze była zapisywana ręcznie, ręcznie także kopiowano informacje. Po wynalezieniu przez Chińczyków, a później przez Gutenberga, czcionek ruchomych i prasy drukarskiej informację zaczęto nanosić na papier mechanicznie. Wynalazek ten pozwolił przyspieszyć zapis informacji, a także umożliwił tworzenie wielu identycznych kopii informacji. Papierowe nośniki danych były także stosowane w systemach komputerowych.

Zapisany nośnik przechowywany jest w określonym środowisku. Oddziaływanie czynników zewnętrznych na nośnik może doprowadzić do zniekształcenia lub całkowitego usunięcia zmian wywoływanych podczas zapisu – poprawny odczyt jest wtedy niemożliwy. Dodajmy, że może dojść do sytuacji, w której odczyt jest możliwy, jednak interpretacja tego, co odczytano jest niemożliwa. Dzieje się tak wtedy, kiedy nośnik przetrwał, ale informację zapisano z użyciem niezrozumiałego, w momencie odczytu, języka. Na Krecie w drugim tysiącleciu p.n.e. stosowano pismo nazywane obecnie linearnym A. Tabliczki gliniane z tekstami zapisanymi tym pismem przetrwały do dzisiaj. Mimo, iż umieszczone na nich symbole są rozpoznawalne, nie można zinterpretować ich znaczenia.

Historia nośników

Terminem nośnik informacji będziemy określali obiekt materialny, na którym jest utrwalona określona informacja w postaci fizycznych zmian własności obiektu.

Karta perforowana

Karty i taśmy perforowane były stosowane we francuskich warsztatach tkackich, szafach grających, pianolach, tabulatorach, a wreszcie w komputerach. Po raz pierwszy karty perforowane zostały zastosowane w krosnach tkackich. W 1725 roku Basile Bouchon wprowadził perforowane karty papierowe do krosna nicielnicowego. Zastosowanie kart z otworami pozwoliło częściowo zautomatyzować pracę krosna. Od rozmieszczenia otworów na karcie zależał wzór tkany na płótnie. W kolejnych latach oprócz kart stosowano także walce perforowane, zwoje papieru i zestawy kart połączonych ze sobą. Najbardziej znane i najpowszechniej stosowane były krosna budowane na początku XIX wieku przez Josepha Marie Jacuarda.

Krosno z obsługą kart dziurkowanych 1825

r.

Użycie kart perforowanych planował także Charles Babbage w swoim projekcie maszyny analitycznej z 1840 roku. W krosnach karty sterowały działaniem, natomiast Babbage zamierzał zastosować różne typy kart do dwóch celów: sterowania i wprowadzania wartości liczbowych. Zakładał także, że karty najczęściej używane byłyby wykonane z blachy cynkowej. Ze względu na brak możliwości technologicznych, maszyny Babbage’a nie

zbudowano w tamtym okresie. Pierwszy egzemplarz maszyny został zbudowany dopiero pod koniec lat 80. XX wieku. Urządzenie okazało się w pełni sprawne i zdolne dokonywać obliczeń z dokładnością do 31 cyfr, co wielokrotnie przekracza możliwości współczesnego kalkulatora kieszonkowego.

Rekonstrukcja maszyny analitycznej Charles’a

Babbage’a.

W 1887 Herman Hollerith opatentował własny format karty dziurkowanej, która została użyta podczas powszechnego spisu ludności USA w 1890 roku. Opracowany na te potrzeby system kodowania zbieranych informacji oparty był właśnie na tych kartach. Informacje kodowano poprzez wycinanie otworów w odpowiednich miejscach, gdy odpowiedź na pytanie była twierdząca. Karty mogły być następnie segregowane lub zliczane, w zależności od wyciętych otworów. Karta Holleritha miała wymiary ówczesnego banknotu dolarowego tzn. 90 na 215 mm, otwory były okrągłe.

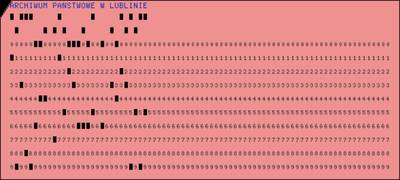

Karta perforowana z zapisanym tekstem o

treści: „ARCHIWUM PANSTWOWE W LUBLINIE”.

Informacja na nośniku papierowym jest najczęściej naniesiona na powierzchnię i zapisana jako tekst, rysunek lub obraz, ale może być także reprezentowana przez odpowiednie ukształtowanie krawędzi kartki lub wykonanie otworów w jej powierzchni.

W najprostszym wypadku informacja jest reprezentowana przez brak lub obecność pojedynczego otworu w dowolnym miejscu papierowego nośnika – oczywiście ta metoda daje możliwość reprezentowania pojedynczego bitu informacji. Znacznie więcej możliwości daje stosowanie wielu otworów i ustalenie miejsc ich pojawienia się na nośniku papierowym.

Zaletą zapisu za pomocą otworów, w odniesieniu do tekstu czy obrazu umieszczonego na kartce, była w przeszłości możliwość mechanicznego lub elektrycznego wykrywania istnienia otworów, a więc odczytywania informacji bez udziału człowieka, a następnie automatycznego wykonywania czynności zależnej od odczytanej informacji.

Podobną możliwość automatycznego odczytywania zapisu z nośnika daje stosowanie atramentu przewodzącego prąd. Próby użycia takiej technologii podjęto w połowie lat trzydziestych XX wieku. Przykładowo, w 1937 roku w firmie IBM opracowano maszynę o nazwie IBM Type 805 International Test Scoring Machine, do automatycznego podliczania wyników testów wypełnianych przy użyciu takiego atramentu.

IBM Type 805 International Test Scoring

Machine.

Wkrótce po wprowadzeniu do użytku kart perforowanych i maszyn sortujących znaleziono dla nich wiele innych zastosowań. Używano ich między innymi na kolei i w towarzystwach ubezpieczeniowych. W miarę upływu czasu doskonalono i wprowadzano nowe urządzenia. W 1901 opatentowano klawiszową dziurkarkę kart. Pięć lat później opracowano automatyczny podajnik kart, pracujący z szybkością 150 kart/min.

Pierwsze karty pozwalały na zapisanie odpowiedzi typu „tak/nie” lub „1 z wielu”. Stopniowo wprowadzano karty umożliwiające wyrażanie liczb, a następnie liczb i tekstów.

Z upływem lat karty perforowane stały się nośnikiem danych stosowanym masowo. Przykładowo, pod koniec lat trzydziestych XX wieku przedsiębiorstwo kolejowe w Czechach zużywało około 50 mln kart rocznie. Drukarnia kart w Warszawie wytwarzała 36 mln kart rocznie. Przed II wojną światową we Francji zużywano około 200 mln kart rocznie. Na początku lat czterdziestych XX wieku produkcja kart perforowanych w Niemczech wynosiła 1,5 mld rocznie. Używane w tych latach tabulatory segregowały z szybkością do 25 tysięcy kart/h.

Biorąc pod uwagę fakt, że na pojedynczej, 80-kolumnowej karcie kodowano do osiemdziesięciu znaków (równorzędnych używanym dziś osiemdziesięciu bajtom) i że każde 80 bajtów miało grubość 0,18 milimetra, można oszacować, że do zakodowania 80 gigabajtów dysku twardego potrzebny byłby stos kart o wysokości ponad 0,18 miliarda milimetrów, czyli 180 kilometrów, ważący ponad dwa tysiące ton.

System dziurkowanych kart jako nośników danych, jak już wspomniano, w zasadzie wyszedł z użycia w latach 80., choć stosowano go jeszcze incydentalnie również później. Szczególnie głośny stał się przypadek jego zastosowania w czasie amerykańskich wyborów prezydenckich w roku 2000, kiedy nieprawidłowo opracowany system kodowania danych w połączeniu z typowym dla perforowanych papierowych nośników danych problemem pozostających w otworach resztek doprowadził do skandalu i potrzeby ponownego, ręcznego sprawdzenia wszystkich kart w stanie Floryda.

Taśmy magnetyczne

Zasady magnetycznego zapisu informacji opisał w 1888 roku Oberlin Smith. Nie wykonał on jednak eksperymentów. Dopiero wiele lat później zademonstrowano pierwsze urządzenie. W 1898 roku Valdemar Poulsen, duński inżynier zajmujący się telefonią, wynalazł i opatentował telegrafon – urządzenie do zapisu mowy, w którym wykorzystano zjawiska magnetyczne.

Telegrafon Valdemara Poulsen’a.

Dźwięk był zapisywany w drucie stalowym o średnicy 1mm. Poulsen użył struny fortepianowej. Drut był magnesowany przez elektromagnes, w którym prąd był wzbudzony przez mikrofon telefoniczny.

Telegrafon publicznie zademonstrowano w 1900 roku na Światowej Wystawie w Paryżu. Zarejestrowano na niej nagranie głosu cesarza Franciszka Józefa, które jest przechowywane w Duńskim Muzeum Nauki i Technologii.

W 1927 roku austriacki wynalazca zastąpił taśmę stalową taśmą papierową pokrytą sproszkowanym materiałem magnetycznym.

W 1931 roku w Niemczech rozpoczęto prace nad pierwszym magnetofonem, rejestrującym dźwięk na taśmie magnetycznej w formie zbliżonej do stosowanych obecnie.

Pod koniec II wojny światowej w Niemczech opracowano taśmę celuloidową pokrytą warstwą z granulkami tlenku żelazowego o średnicy rzędu mikrometrów. Taśma magnetofonowa firmy BASF z 1945 roku miała 1000 m długości, 6,5 mm szerokości i pozwalała na nagranie 20 minut dźwięku.

Pierwszy magnetofon stereofoniczny opracowano w 1949 roku. W połowie lat sześćdziesiątych rozpoczęto produkcję magnetofonów wielościeżkowych przeznaczonych dla studiów nagraniowych.

Po raz pierwszy magnetyczną pamięć taśmową do zapisu danych zastosowano w firmie IBM, w której skonstruowano urządzenie IBM 726 współpracujące z komputerem IBM 701 Defense Calculator.

IBM 701 Defense Calculator.

Dyski magnetyczne

Pierwsze konstrukcje cyfrowych pamięci dyskowych powstały w firmie IBM w latach pięćdziesiątych XX wieku. W 1956 roku zbudowano w tej firmie urządzenie o nazwie IBM 350 RAMAC Disk File. Urządzenie to składało się z 50 dwustronnych dysków aluminiowych pokrytych warstwą tlenku żelaza. Dyski o średnicy 61 cm były zamontowane na stałe, a całkowita ich pojemność wynosiła 4,5 MB.

IBM 350 RAMAC Disk File.

W 1962 roku urządzenie o nazwie IBM 1311 Disk Storage Drive było pierwszym systemem pamięci z wymiennymi pakietami dysków. Pakiet składał się z kilku dysków o łącznej pojemności 2 milionów znaków.

9IBM 1311 Disk Storage Drive.

Jednym z protoplastów współczesnych, twardych dysków magnetycznych było urządzenie IBM 3030 opracowane w 1973 roku. System składał się z dwóch zestawów dysków o pojemności 30 MB każdy.

IBM 3030

Pierwsze dyski dla komputerów osobistych były urządzeniami umieszczanymi w oddzielnych obudowach, które oprócz dysku zawierały kartę sterownika i własny zasilacz. Jednym z pierwszych modeli był Seagate ST-506 o pojemności 5 MB.

Dyski wymienne

Wymienny dysk magnetyczny jest jednym z prostszych i tańszych nośników danych. Pamięć w postaci wymiennego dysku magnetycznego jako pierwszy opracował i opatentował w latach pięćdziesiątych XX wieku Yoshiro Nakamatsu z Uniwersytetu Tokijskiego. Patent wykupiła i wdrożyła firma IBM.

Pierwsza dyskietka magnetyczna miała średnice 20,32 cm (8 cali) i pojemność nieprzekraczającą 100 kB. W 1973 roku powstały dyskietki jednostronne o pojemności 156 kB. W 1975 roku wymienne dyski stosowane w komputerach PDP 11/45 miały już pojemność 2,4 MB.

Dyskieta 8”

W 1976 roku opracowano pierwszy powszechny standard dyskietek o średnicy 5,25 cala. Dyskietki tego typu, miały pojemność 220 kB.

Dyskieta 5,25”

Dyskietka, która zdobyła największą popularność jest dyskietka z politereftalanu etylenu o średnicy 8,89 mm czyli 3,5 cala. Nośnik ten opracowała firma Sony w 1981 roku i początkowo miał pojemność 440 kB. Był stosowany zarówno w komputerach IBM PC, Atari ST, Amiga, jak i w Apple.

Dyskietka 3,5”

W 1984 roku pojawiły się jeszcze dyskietki 3” początkowo o pojemności 360 kB. Nie zdobyły większej popularności. Wykorzystywane były między innymi w takich komputerach 8-bitowych jak ZX Spectrum i Amstrad.

Dyskietka 3”

Pamięć optyczna

Prace nad cyfrową pamięcią optyczną były prowadzone od końca lat sześćdziesiątych XX wieku. W 1968 roku naukowcy z firmy IBM stworzyli doświadczalny system pamięci optycznej z użyciem wiązki lasera. Do dynamicznego rozwoju i upowszechnienia doszło między innymi dzięki opracowaniu technologii produkcji tanich diod laserowych.

W połowie lat osiemdziesiątych były używane cyfrowe płyty optyczne DOR. Płyta DOR pozwalała na przechowywanie około 2 GB informacji. W 1984 roku dostępne były dyski optyczne o średnicy 30,48 cm (12 cali) i pojemności 1 GB.

Laser disk 12”

Porównanie wielkości Laser disk z płytą

CD

Dwa lata później pojemność zwiększono do 2 GB. W 1996 roku firma Philips produkowała dwustronne dyski jednokrotnego zapisu o pojemności 12 GB. Optyczne nośniki danych przyjmowały formę nie tylko dysków, ale także pasków umieszczonych na obracających się bębnach.

Jednak technologią, która upowszechniła się na skalę masową, jest technologia Compact Disk opracowana przez firmy Sony i Philips. Jako pierwszy powstał standard dysku dźwiękowego CD-DA zaprezentowany w 1980 roku. W 1985 wprowadzono standard CD-ROM, a następnie w roku 1990 – CD-R i w 1995 CD-RW.

Standardowy dysk CD ma grubość 1,2 mm i średnicę 120 mm lub 80 mm, a gęstość zapisu wynosi około 6,5 MB/cm2.

W związku z coraz większymi wymaganiami, stawianymi przez aplikacje multimedialne, możliwości technologii CD stały się niewystarczające. W celu rozwiązania tego problemu opracowano standard płyt DVD.

Zwiększenie pojemności w płytach DVD osiągnięto, stosując kilka udoskonaleń w stosunku do technologii CD. Zachowując te same wymiary zewnętrzne nośnika, zwiększono powierzchnię dostępną do zapisu informacji.

Tabela 1. Standardy dysków DVD-ROM

Kolejnym etapem rozwoju są płyty HD-DVD i Blu-ray.

W zapisie i odczycie dysku optycznego pojemność nośnika zależy od średnicy plamki, do jakiej daje się zogniskować wiązkę lasera. Natomiast wielkość plamki zależy od długości fali laserowej. Prace nad nośnikami optycznymi sprowadzają się do poszukiwania technologii stosujących coraz krótsze fale laserowe. W technologii CD stosowano fale podczerwone o długości 780 nm, w DVD – fale czerwone o długości 635 i 650 nm.

W dyskach HD-DVD stosuje się fale o długości 405 nm i układ optyczny z soczewkami o aperaturze 0.65, uzyskując przy tym pojemność użytkową jednej warstwy na poziomie 15 GB. W płytach Blu-ray także stosuje się fale o długości 405 nm, zwiększono aperaturę soczewki do 0,85. Dzięki temu uzyskano 5-krotnie większą pojemność w porównaniu z DVD.

Dysk DVR-Blue, jednostronny, jednowarstwowy ma pojemność 27,4 GB, a dwuwarstwowy – około 50 GB.